Benutzer:ElTom/Baustelle

Basierend auf diesem Artikel [3]

Künstliche Intelligenz (KI, engl. artificial intelligence, AI) ist ein Teilgebiet der Informatik, das sich mit der Automatisierung intelligenten Verhaltens befasst. Obwohl es keine allgemein anerkannte Definition von Intelligenz gibt, wird der Begriff künstliche Intelligenz in weiten Teilen der Forschung und Entwicklung angewendet.

Überblick

[Bearbeiten | Quelltext bearbeiten]Im Verständnis des Begriffs künstliche Intelligenz spiegelt sich oft die aus der Aufklärung stammende Vorstellung vom „Menschen als Maschine“ wider, dessen Nachahmung sich die so genannte starke KI zum Ziel setzt: eine Intelligenz zu erschaffen, die wie der Mensch kreativ nachdenken und Probleme lösen kann und die sich durch eine Form von Bewusstsein beziehungsweise Selbstbewusstsein sowie Emotionen auszeichnet. Die Ziele der starken KI sind nach Jahrzehnten der Forschung weiterhin visionär.

Im Gegensatz zur starken KI geht es der schwachen KI um das Lösen konkreter Anwendungsprobleme, wie Sprach- oder Mustererkennung, Analysen und Prognosen von Aktienkursen oder Planungsproblemen. Insbesondere sind dabei solche Anwendungen von Interesse, zu deren Lösung nach allgemeinem Verständnis eine Form von „Intelligenz“ notwendig zu sein scheint. Letztlich geht es der schwachen KI somit um die Simulation intelligenten Verhaltens mit Mitteln der Mathematik und der Informatik, es geht ihr nicht um Schaffung von Bewusstsein oder um ein tieferes Verständnis von Intelligenz. Während die starke KI an ihrer philosophischen Fragestellung bis heute scheiterte, sind auf der Seite der schwachen KI in den letzten Jahren bedeutende Fortschritte erzielt worden.

Neben den Forschungsergebnissen der Kerninformatik selbst sind in die KI Ergebnisse der Psychologie und Neurologie, Mathematik und Logik, Kommunikationswissenschaft, Philosophie und Linguistik eingeflossen. Die Beeinflussung der Neurologie hat sich in der Ausbildung des Bereichs Neuroinformatik gezeigt, der der biologieorientierten Informatik zugeordnet ist. Zusätzlich ist auch der ganze Zweig der Kognitionswissenschaft zu nennen, welcher sich wesentlich auf die Ergebnisse der künstlichen Intelligenz in Zusammenarbeit mit der kognitiven Psychologie stützt.

Geschichte der KI

[Bearbeiten | Quelltext bearbeiten]Anfänge

[Bearbeiten | Quelltext bearbeiten]Im Sommer 1956 organisierten John McCarthy, Marvin Minsky, Nathaniel Rochester und Claude Shannon am Dartmouth College einen zweimonatigen Workshop. Das Ziel dieser Darthmouth Conference war, amerikanische Forscher, welche an der Erforschung von neuronalen Netzen und Intelligenz interessiert waren, zusammen zu bringen. Im Förderantrag an die Rockefeller Foundation prägte McCarthy das erste Mal den Begriff Künstliche Intelligenz. [1]

Turing-Test

[Bearbeiten | Quelltext bearbeiten]

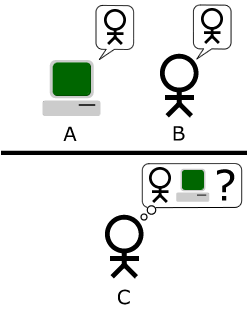

Um ein Maß zu haben, wann eine Maschine eine dem Menschen gleichwertige Intelligenz simuliert, wurde von Alan Turing der nach ihm benannte Turing-Test vorgeschlagen. Dabei stellt ein Mensch per Terminal (also ohne Sicht- bzw. Hörkontakt zu den Teilnehmern) einem anderen Menschen und einer KI beliebige Fragen. Der Fragesteller muss danach entscheiden, wer von den beiden Befragten die Maschine ist. Ist die Maschine nicht von dem Menschen zu unterscheiden, so ist laut Turing die Maschine intelligent.[2] Bisher hat keine Maschine diesen Turing-Test bestanden. Seit 1991 existiert der Loebner-Preis für den Turing-Test.

Die Rolle des Gehirns

[Bearbeiten | Quelltext bearbeiten]Eines der ersten Programme, welches ansatzweise menschlich denken konnte, war der General Problem Solver (GPS) von Allen Newell und Herbert Simon. Es konnte einfache logische Rätsel mit menschenähnlichen Strategien lösen. Die Erkenntnisse aus diesem und weiteren Programmen verhalf Newell und Simon dazu, ihre berühmte physische Symbolsystemhypothese zu formulieren. Sie besagt, dass Denken nichts weiter als das Manipulieren von Datenstrukturen ist, welche aus Symbolen bestehen: „Intelligence is mind implemented by any patternable kind of matter.“[3]

Künstliche Intelligenz beim Schach

[Bearbeiten | Quelltext bearbeiten]

Insbesondere die Anfangsphase der KI war geprägt durch eine fast grenzenlose Erwartungshaltung im Hinblick auf die Fähigkeit von Computern, „Aufgaben zu lösen, zu deren Lösung Intelligenz notwendig ist, wenn sie vom Menschen durchgeführt werden“ [4]. Simon sagte 1957 voraus, dass innerhalb der nächsten 10 Jahre Computer Schachweltmeister werden und einen wichtige mathematische Thesen entdecken und beweisen würden. Da das nicht zutraf, wiederholte Simon diese Vorhersage, allerdings ohne Zeitangabe. 1997 gelang es genau 40 Jahre nach Simons Prognose Deep Blue, einem von IBM entwickeltem Supercomputer, Schach-Weltmeister Garry Kasparov in sechs Partien zu schlagen.

ELZIA

[Bearbeiten | Quelltext bearbeiten]

Ende der 1960er Jahre entwickelte Joseph Weizenbaum am MIT mit einer relativ simplen Strategie das Programm ELIZA, in dem der erste Dialog eines Psychiaters mit seinem Patienten simuliert wird. Die Wirkung des Programms war überwältigend. Weizenbaum war selbst überrascht, dass man auf relativ einfache Weise Menschen die Illusion eines menschlichen Partners vermitteln kann.[5]

Expertensysteme

[Bearbeiten | Quelltext bearbeiten]→ Hauptartikel: Expertensysteme

1969 entwickelten Edward Feigenbaum, Bruce Buchanan und Joshua Lederberg erste Ansätze, wie regelbasiertes Wissen zur Lösung von Problemen herangezogen werden konnte. Ihr Programm konnte auf Grundlage der chemischen Formel und der Massen der enthaltenen Atome vorhersagen, wie das Massenspektrum eines chemischer Moleküls aussieht.

Eines der bekanntesten Expertensysteme, war das Anfang der 1970er Jahre von T. Shortliffe an der Stanford University entwickelte System MYCIN zur Unterstützung von Diagnose- und Therapieentscheidungen bei Blutinfektionskrankheiten und Meningitis. In der Evaluation wurde festgestellt, dass seine Entscheidungen so gut sind wie die eines Experten in dem betreffenden Bereich und besser als die eines Nicht-Experten.[6]

Neuronale Netze

[Bearbeiten | Quelltext bearbeiten]Mit den Neuronalen Netzen trat zur gleichen Zeit eine neue Perspektive der KI ans Licht, angestoßen u.a. von Arbeiten des finnischen Ingenieurs Teuvo Kohonen. In diesem Bereich der schwachen KI löste man sich von Konzepten von „Intelligenz“ und analysierte stattdessen, ausgehend von der Neurophysiologie, die Informationsarchitektur des menschlichen Gehirns. Die Modellierung in Form künstlicher neuronaler Netze illustrierte dann, wie aus einer sehr einfachen Grundstruktur eine komplexe Musterverarbeitung geleistet werden kann. Die Neuroinformatik hat sich als wissenschaftliche Disziplin zur Untersuchung dieser Verfahren entwickelt.

Dabei wird deutlich, dass diese Art von Lernen im Gegensatz zu Expertensystemen nicht auf der Herleitung und Anwendung von Regeln beruht. Daraus folgt auch, dass die besonderen Fähigkeiten des menschlichen Gehirns nicht auf einen solchen regel-basierten Intelligenz-Begriff reduzierbar sind. Die Auswirkungen dieser Einsichten auf die KI-Forschung, aber auch auf Lerntheorie, Didaktik, das Verhältnis zum Bewusstsein und andere Gebiete werden noch diskutiert.

Methoden und Teilgebiete der KI

[Bearbeiten | Quelltext bearbeiten]Viele ältere Methoden, die in der KI entwickelt wurden, basieren auf heuristischen Lösungsverfahren. In jüngerer Zeit spielen mathematisch fundierte Ansätze aus der Statistik, der Mathematischen Programmierung und der Approximationstheorie eine bedeutende Rolle.

Die konkreten Techniken der KI lassen sich grob in Gruppen einteilen:

Suchen

[Bearbeiten | Quelltext bearbeiten]Die KI beschäftigt sich häufig mit Problemen, bei denen nach bestimmten Lösungen gesucht wird. Verschiedene Suchalgorithmen werden dabei eingesetzt. Ein Paradebeispiel für die Suche ist der Vorgang der Wegfindung, der in vielen Computerspielen eine zentrale Rolle einnimmt und auf Suchalgorithmen wie zum Beispiel dem A*-Algorithmus basiert.

Planen

[Bearbeiten | Quelltext bearbeiten]Beim Planen haben Agentensysteme die Aufgabe, auf Basis von bestimmten Zuständen eine Folge von Aktionen zu finden, die zum definierten Ziel führen. Je nach Problemtyp kann dabei beispielsweise auf Heuristiken oder partielles Planen zurückgegriffen werden. Viele Planungssysteme nehmen an, dass viele Probleme der realen Welt partiell zerlegbar sind und planen deshalb nur Unterprobleme, um sie am Ende zu einer Lösung zusammenzusetzen.

Optimierungsmethoden

[Bearbeiten | Quelltext bearbeiten]Oft führen Aufgabenstellungen der KI zu Optimierungsproblemen. Diese werden je nach Struktur entweder mit Suchalgorithmen aus der Informatik oder, zunehmend, mit Mitteln der Mathematischen Programmierung gelöst. Bekannte heuristische Suchverfahren aus dem Kontext der KI sind Evolutionäre Algorithmen.

Logisches Schließen

[Bearbeiten | Quelltext bearbeiten]Eine Fragestellung der KI ist die Erstellung von Wissensrepräsentationen, die dann für automatisches logisches Schließen benutzt werden können. Menschliches Wissen wird dabei – soweit möglich – formalisiert, um es in eine maschinenlesbare Form zu bringen. Diesem Ziel haben sich die Entwickler diverser Ontologien verschrieben.

Approximationsmethoden

[Bearbeiten | Quelltext bearbeiten]In vielen Anwendungen geht es darum, aus einer Menge von Daten eine allgemeine Regel abzuleiten (maschinelles Lernen). Mathematisch führt dies zu einem Approximationsproblem. Im Kontext der KI wurden hierzu künstliche neuronale Netze vorgeschlagen. In praktischen Anwendungen verwendet man häufig alternative Verfahren, die mathematisch einfacher zu analysieren sind.

Einfluss auf andere Wisschenschaften

[Bearbeiten | Quelltext bearbeiten]Robotik

[Bearbeiten | Quelltext bearbeiten]

→ Hauptartikel: Robotik

Roboter sind physische Agenten, die neben Sensoren zur Wahrnehmung ihrer Umgebung auch mit Effektoren wie Greifarme, Räder oder Beine zur Umgebungsmanipulation ausgestattet sind.

Bei Robotern wird zwischen drei Typen unterschieden. Manipulatoren haben einen festen Arbeitsbereich, in dem sie zum Beispiel einen Roboterarm bewegen und etwas Montieren. Sie sind in der Industrie gebräuchlich. Mobile Roboter können sich mit Rädern, Schienen oder Beinen selbstständig fortbewegen, wie zum Beispiel eine führerlose U-Bahn. Der dritte Typ ist der humanoide Roboter, der sich fortbewegen kann und Manipulatoren hat. Dieser Robotertyp muss seine Effektoren steuern ohne sich auf seine feste Position wie bei Typ eins verlassen zu können. Der abgebildete ASIMO der Firma Honda ist ein Beispiel für so einen Typ Roboter.

Roboter sollen intelligente Verhaltensweisen von Menschen oder Tieren nachahmen (Typ 3), oder langweilige beziehungsweise für Menschen gefährliche Aufgaben wahrnehmen können (Typ 1 oder Typ 2).

Philosophische Aspekte

[Bearbeiten | Quelltext bearbeiten]Die philosophischen Aspekte der KI-Problematik gehören zu den weitreichendsten der gesamten Informatik.

Die Antworten, die auf die zentralen Fragen dieses Bereichs gegeben werden, reichen weit in ontologische und erkenntnistheoretische Themen hinein, die das Denken des Menschen schon in den Anfängen der Philosophie beschäftigten. Wer solche Antworten gibt, muss die Konsequenzen daraus auch für den Menschen und sich selbst ziehen. Nicht selten möchte man umgekehrt vorgehen und die Antworten, die man vor der Entwicklung künstlicher Intelligenz gefunden hat, auf diese übertragen. Doch wie sich zeigte, hat die künstliche Intelligenz zahlreiche Forscher dazu veranlasst, Probleme wie das Verhältnis von Materie und Geist, die Ursprünge des Bewusstseins, die Grenzen der Erkenntnis, das Problem der Emergenz, die Möglichkeit außermenschlicher Intelligenz usw. in neuem Licht zu betrachten und zum Teil neu zu bewerten.

Eine dem metaphysischen bzw. auch idealistischen Denken verpflichtete Sichtweise hält es (im Sinn einer schwachen KI) für unmöglich, dass Maschinen jemals mehr als nur simuliertes Bewusstsein mit wirklicher Erkenntnis und Freiheit besitzen könnten. Aus ontologischer Sicht kritisiert der amerikanische Philosoph Hubert Dreyfus die Auffassung der starken KI. Aufbauend auf der von Martin Heidegger in dessen Werk Sein und Zeit entwickelten Ontologie der „Weltlichkeit der Welt“ versucht Dreyfus zu zeigen, dass hinter das Phänomen der Welt als sinnhafte Bedeutungsganzheit nicht zurückgegangen werden kann: Sinn, d. h. Beziehungen der Dinge in der Welt aufeinander, ist ein Emergenzphänomen, denn es gibt nicht „etwas Sinn“ und dann „mehr Sinn“. Damit erweist sich jedoch auch die Aufgabe, die sinnhaften Beziehungen zwischen den Dingen der Welt in einen Computer einzuprogrammieren als – nicht nur unendliche – sondern unmögliche. Dies deshalb, weil Sinn nicht durch Addition von zunächst sinnlosen Elementen hergestellt werden kann.[7]

Eine evolutionär-progressive Denkrichtung sieht es hingegen (im Sinn einer starken KI) als möglich an, dass Systeme der künstlichen Intelligenz einmal den Menschen in dem übertreffen könnten, was derzeit noch als spezifisch menschlich gilt. Dies birgt zum einen die Gefahr, dass solche KI-Maschinen missbraucht werden z.B. für militärische Zwecke. Andererseits birgt diese Technologie die Chance, Probleme zu lösen, deren Lösung dem Menschen wegen seines limitierten Verstands nicht möglich ist.

Informatik

[Bearbeiten | Quelltext bearbeiten]Das Problem der unscharfen Intelligenzdefinition spiegelt sich vor allem in der Informatik wieder. Die Abgrenzung von intelligenten Anwendungen scheitert dabei an klaren Grenzen. Zwar erfordern auch einfache Rechenvorgänge wie die Addition zweier Zahlen einen gewissen Grad an Intelligenz, es ist jedoch unüblich auch Addierern Intelligenz zuzusprechen.

Zur Lösung dieses Problems wird oft ein konstruktivistischer Ansatz aus der Psychologie verfolgt, bei dem Intelligenzmerkmale am Menschen beobachtet, und nach Bedeutung geordnet werden. Dabei hat sich herausgestellt, dass besonders drei Merkmale essentiell sind. Intelligente Maschinen müssen beliebige Symbole verarbeiten, ein inneres Modell der äußeren Welt aufbauen und spezialisiertes Wissen anwenden können. Erfüllt die Maschine noch weitere Merkmale, kann ihr ein höherer Intelligenzgrad zugeschrieben werden.

Insgesamt ist bei dem hier beschriebenen konstruktivistischen Ansatz zur Verwendung des Intelligenzbegriffes zu beachten, dass dieser zwar zahlreiche Merkmale definiert und so fassbarer macht, dass andererseits jedoch die Fülle der Merkmale auch verhältnismäßig schwierig zu handhaben ist.

Siehe auch

[Bearbeiten | Quelltext bearbeiten]- Deutsches Forschungszentrum für Künstliche Intelligenz (DFKI)

- European Conference on Artificial Intelligence

- Kybernetik

- Artificial Intelligence System

- Cyc

KI in Romanen und Filmen

[Bearbeiten | Quelltext bearbeiten]- 2001: Odyssee im Weltraum (1968)

- Film von Stanley Kubrick mit dem fiktionalen Computer HAL 9000

- Dark Star (1974)

- Sciencefiction-Parodie: Bombe Nr. 20 führt darin unter anderem philosophische Diskurse.

- Per Anhalter durch die Galaxis (ab 1979)

- Romanreihe von Douglas Adams, in der der Computer Deep Though unter anderem die Antwort 42 findet

- Knight Rider (1980er)

- Das Auto K.I.T.T. dieser Fernsehserie ist mit einer KI ausgestattet.

- Nummer 5 lebt (1986)

- humorvoller Film in dem Nr. 5 ein zum Leben erwachter Roboter ist

- zum Teil kritischer Film mit einem künstlich geschaffenen Roboterkind in der Hauptfigur

- I, Robot (2004)

- Film in einer "robotisierten" Welt rund um die Ermittlungen zu einem Mord durch einen Roboter

- humoresker Film mit einem selbstständig denkenden Roboter in der Hauptfigur

Literatur

[Bearbeiten | Quelltext bearbeiten]Deutsch

[Bearbeiten | Quelltext bearbeiten]- Joseph Weizenbaum: Die Macht der Computer und die Ohnmacht der Vernunft Suhrkamp, 12. Auflage, 1978, ISBN 3-518-27874-6

- Roger Penrose: Computerdenken – Des Kaisers neue Kleider oder die Debatte um künstliche Intelligenz, Bewusstsein und die Gesetze der Natur, Übersetzung der englischen Originalausgabe The Emperor's New Mind, Heidelberg 1991

- Roger Penrose: Schatten des Geistes. Wege zu einer neuen Physik des Bewußtseins Übersetzung aus dem Englischen Shadows of the Mind Heidelberg 1995

- Howard Gardner: Dem Denken auf der Spur (KI als Teil der interdisziplinären Kognitionswissenschaft) Stuttgart 1989 ISBN 3-608-93099-X

- Hubert L. Dreyfus: Was Computer nicht können. Die Grenzen künstlicher Intelligenz. 1989, ISBN 3-610-04723-2

- Hans Moravec: Computer übernehmen die Macht. Vom Siegeszug der künstlichen Intelligenz. Hoffmann und Campe (1999) ISBN 978-3-455-08575-4

- Dietrich Dörner: Bauplan für eine Seele. Rowohlt, Reinbek 2001, ISBN 3-499-61193-7

- Jörg Auf dem Hövel: Abenteuer Künstliche Intelligenz. Auf der Suche nach dem Geist in der Maschine Hamburg 2002 ISBN 3-9807330-4-1

- Klaus Mainzer: Künstliche Intelligenz. Grundlagen intelligenter Systeme Darmstadt 2003

- Stuart Russell, Peter Norvig: Künstliche Intelligenz: Ein moderner Ansatz, August 2004, Pearson Studium, ISBN 3-8273-7089-2 (deutsche Übersetzung der 2. Auflage)

- Rodney Brooks: Menschmaschinen. Wie uns die Zukunftstechnologien neu erschaffen Fischer (Tb.), Frankfurt; (April 2005) ISBN 978-3-596-15877-5

- Bernd Vowinkel: Maschinen mit Bewusstsein – Wohin führt die künstliche Intelligenz?. Wiley-VCH (Mai 2006) ISBN 978-3-527-40630-2

- Uwe Lämmel, Jürgen Cleve: Künstliche Intelligenz, 3. Auflage 2008, Carl Hanser Verlag München, ISBN 978-3-446-41398-6

Englisch

[Bearbeiten | Quelltext bearbeiten]- Marvin Minsky: Mentopolis Stuttgart 1990 ISBN 3-608-93117-1

- Ray Kurzweil: The Age of Spiritual Machines. B&T (Januar 2000) ISBN 978-0-14-028202-3

- Rolf Pfeifer, Christian Scheier, Alex Riegler: Understanding Intelligence Bradford Books, 2001, ISBN 0-262-66125-X

- Michael Kary, Martin Mahner: How Would You Know if You Synthesized a Thinking Thing? Minds and Machines 12, 2002, 61–86.

Weblinks

[Bearbeiten | Quelltext bearbeiten]Deutsch

[Bearbeiten | Quelltext bearbeiten]- Daniela Hallegger: Maschinen lernen Denken (Technische Universität Wien, 28. April 2008 – über das junge Forschungsgebiet „Machine Perception“; Bericht: [4])

- KI-Zeitschrift mit teilweise kostenlosen Artikeln im PDF-Format

- Wer hat Geist und wer nicht? (deutsche Kurzfassung einer Science-Studie)

- Der Mensch und die Künstliche Intelligenz Dissertation (PDF), zusätzlich als Hörbuch-Version (mp3 sowie flash)

- Embodiment: Nur durch den lebendigen Körper läßt sich der Geist verstehen – mit Folgen für die KI-Forschung. Sendung des Deutschlandfunk, auch als Hörbeitrag rechts auf der Seite abrufbar.

Englisch

[Bearbeiten | Quelltext bearbeiten]- Artificial Intelligence Wiki

- European Coordinating Committee for Artificial Intelligence (ECCAI)

- Journal of Artificial Intelligence Research (JAIR)

- Larry Hauser: Artificial Intelligence. In: J. Fieser, B. Dowden (Hrsg.): Internet Encyclopedia of Philosophy.

- Richmond Thomason: Logic and Artifical Intelligence. In: Edward N. Zalta (Hrsg.): Stanford Encyclopedia of Philosophy.

- Architecture of Biological and Artifical Intelligence - Dr. Rainer K. Liedtke

Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ [1] Förderantrag für die Dartmouth Conference von 1955

- ↑ Alan Turing: Computing Machinery and Intelligence. Aus: Mind No. 236. Oktober 1950.

- ↑ Ronald Chrisley und Sander Begeer: Artificial Intelligence: Critical Concepts. Taylor & Francis, 2000. S. 479

- ↑ Raymond Kurzweil: KI. Das Zeitalter der Künstlichen Intelligenz. Carl Hanser Verlag, 1993. S.14

- ↑ Joseph Weizenbaum: Die Macht der Computer und die Ohnmacht der Vernunft. Suhrkamp, 1978.

- ↑ [2] Der Artikel zu MYCIN als PDF bei stanford.edu

- ↑ Vgl. Hubert Dreyfus: In-der-Welt-sein und Weltlichkeit: Heideggers Kritik des Cartesianismus. in: Thomas Rentsch: Sein und Zeit. Akademie Verlag, Berlin 2001, S. 69ff

Kategorie:Kybernetik

Kategorie:Kognitionswissenschaft

Kategorie:Angewandte Linguistik

Kategorie:Maschinelles Lernen